Google Now introdujo un concepto muy interesante y que me gustó mucho: el teléfono consciente del contexto del usuario, a partir de la posición, hora, lista de tareas y una larga lista, poder aportar información de valor o recordatorios. ¿Qué pasa cuando se intenta llevar ese concepto más allá? Un teléfono no sólo consciente del contexto del usuario, sino de su estado.

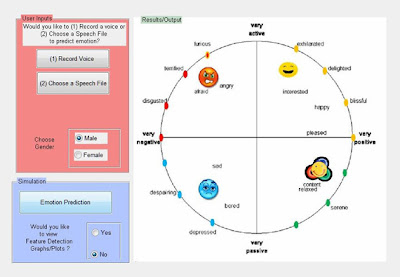

Y no me refiero a un “¿Te cuento un chiste?” cuando le dices a Siri que estás triste, me refiero a que el teléfono pueda saber tu estado anímico a través del reconocimiento de voz. Es en lo que un grupo del IEEE está trabajando, un nuevo algoritmo (que resultará en un programa) que permita saber el estado de ánimo del usuario de acuerdo a su voz, pero, sorprendentemente, siquiera tiene en cuenta el significado de las palabras para la tarea.

De hecho usamos grabaciones de actores leyendo la fecha del mes, realmente no importa mucho lo que estén diciendo, es cómo lo dicen lo que nos interesa.

Comenta Wendi Heinzelman, una de las profesoras guías del proyecto. Según Heinzelman lo que les interesa son 12 características del habla, como el volumen y tono, para poder reconocer una de las seis emociones, logrando un impresionante 81% de aciertos (los estudios previos a duras penas conseguían un 55%). De hecho ya hay una versión de prototipo hecha desarrollada por Na Yang durante su beca en Microsoft Research.

En realidad es una tarea muy complicada, ya que estudiar cuáles son los factores que, con certeza, ayuden a determinar cómo se siente una persona; por eso están trabajando con psicólogos para intentar parametrizar mejor los algoritmos. Si nos abstraemos un poco nos damos cuenta de que esto significa enseñarle a una máquina cómo funcionan los seres humanos, cómo reconocerlos. Por otro lado supone descomponer los sentimientos en medidas cuantificables, cosa que los humanos hacemos de forma natural (podemos intuir si alguien está enfadado o feliz hablando con él), pero convertirlo a números supone enseñarle a un ordenador cómo suena “enfadado” o cómo se oye a alguien triste. Todo se complica más cuando se quiere ampliar a un espectro amplio de individuos con tan diferentes formas de expresar sus emociones, por lo que el algoritmo debe ir adaptándose a su usuario particular e ir aprendiendo de este; el problema es que aún se necesita interacción con el usuario para irle enseñando cuándo es un estado y cuándo otro.

Aplicaciones prácticas de por medio, es un buen avance que permitiría cosas como playlists adaptadas a tu estado o niveles de personalización abrumadores que dependan del momento en el que uses el terminal, que sea un teléfono adaptado incluso a la manera como estás pensando en ese momento.

-

6 de diciembre de 2012

Suscribirse a:

Enviar comentarios (Atom)

Noticias del mes

-

►

2011

(313)

- ► septiembre (24)

-

▼

2012

(195)

- ► septiembre (15)

-

▼

diciembre

(15)

- Google hace llegar Snapseed a Android, y la convie...

- Las descargas de aplicaciones desde Amazon aumenta...

- ¿Teléfonos con inteligencia emocional?

- Yahoo renueva a Flickr para iPhone

- BlackBerry 10 L-Series, ahora en vídeo

- Microsoft Surface se podrá comprar en tiendas de t...

- Apple actualiza iOS 6 para resolver problemas de W...

- Los Samsung Galaxy S III pueden averiarse a los se...

- Google Maps para iOS ha sido descargado diez millo...

- Sony Xperia T se actualiza por navidad a Jelly Bean

- El 99% de los virus móviles de 2012 fue para Android

- Aumentan las medidas anti-jailbreak en la futura v...

- Ouya, la consola con Android

- Hello Friends para Windows Phone 8

- Google ha publicado su lista con las mejores aplic...

No hay comentarios:

Publicar un comentario